- ผู้เขียน Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- แก้ไขล่าสุด 2025-01-22 17:42.

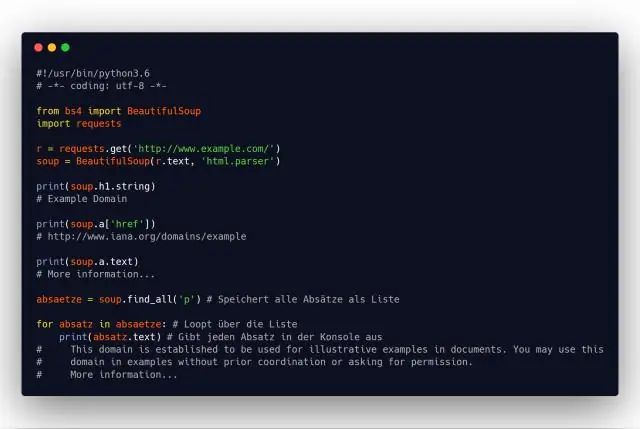

ในการดึงข้อมูลโดยใช้การขูดเว็บด้วย python คุณต้องทำตามขั้นตอนพื้นฐานเหล่านี้:

- ค้นหา URL ที่คุณต้องการขูด

- การตรวจสอบหน้า.

- ค้นหา ข้อมูล คุณต้องการสกัด

- เขียนรหัส

- รันโค้ดและแตกไฟล์ ข้อมูล .

- เก็บ ข้อมูล ในรูปแบบที่ต้องการ

เมื่อพิจารณาถึงสิ่งนี้ การขูดเว็บใน Python คืออะไร

การขูดเว็บ โดยใช้ Python . ขูดเว็บ เป็นคำที่ใช้อธิบายการใช้โปรแกรมหรืออัลกอริธึมในการดึงและประมวลผลข้อมูลจำนวนมากจาก เว็บ . ไม่ว่าคุณจะเป็นนักวิทยาศาสตร์ข้อมูล วิศวกร หรือใครก็ตามที่วิเคราะห์ชุดข้อมูลจำนวนมาก ความสามารถในการ ถู ข้อมูลจาก เว็บ เป็นทักษะที่มีประโยชน์ที่จะมี

นอกจากนี้ Excel สามารถดึงข้อมูลจากเว็บไซต์ได้หรือไม่ คุณ สามารถ นำเข้าตารางได้อย่างง่ายดาย ข้อมูลจากหน้าเว็บ เข้าไปข้างใน Excel และอัพเดทตารางสดเป็นประจำ ข้อมูล . เปิดแผ่นงานใน Excel . จาก ข้อมูล เมนูเลือกนำเข้าภายนอก ข้อมูล หรือรับภายนอก ข้อมูล . ใส่ URL ของ หน้าเว็บ ที่คุณต้องการนำเข้า ข้อมูล และคลิกไป

ในแง่นี้ คุณจะขูดเว็บไซต์ด้วย Python และ BeautifulSoup ได้อย่างไร

อันดับแรก เราต้องนำเข้าไลบรารีทั้งหมดที่เราจะใช้งาน ถัดไป ประกาศตัวแปรสำหรับ url ของหน้า จากนั้นใช้ประโยชน์จาก Python urllib2 เพื่อรับหน้า HTML ของ url ที่ประกาศ สุดท้าย แยกหน้าออกเป็น ซุปที่สวยงาม รูปแบบให้เราได้ใช้ ซุปที่สวยงาม ในการทำงานกับมัน

การขูดข้อมูลเว็บไซต์ถูกกฎหมายหรือไม่

มักจะ, เว็บไซต์ จะอนุญาตให้บุคคลที่สาม ขูด . ตัวอย่างเช่น ส่วนใหญ่ เว็บไซต์ ให้สิทธิ์ Google โดยชัดแจ้งหรือโดยปริยายในการจัดทำดัชนี เว็บ หน้า. แม้ว่า ขูด มีอยู่ทั่วไปก็ไม่ชัดเจน ถูกกฎหมาย . อาจมีกฎหมายหลากหลายบังคับใช้กับผู้ไม่ได้รับอนุญาต ขูด รวมถึงสัญญา ลิขสิทธิ์ และการล่วงละเมิดกฎหมายทรัพย์สิน

แนะนำ:

คุณสามารถเรียก python จาก C # ได้หรือไม่

C จากซอร์สโค้ด Python) การเรียกใช้ฟังก์ชัน Python เป็นเรื่องง่าย ขั้นแรก โปรแกรม Python จะต้องส่งผ่านอ็อบเจ็กต์ฟังก์ชัน Python ให้คุณ คุณควรจัดเตรียมฟังก์ชัน (หรืออินเทอร์เฟซอื่น ๆ ) เพื่อทำสิ่งนี้

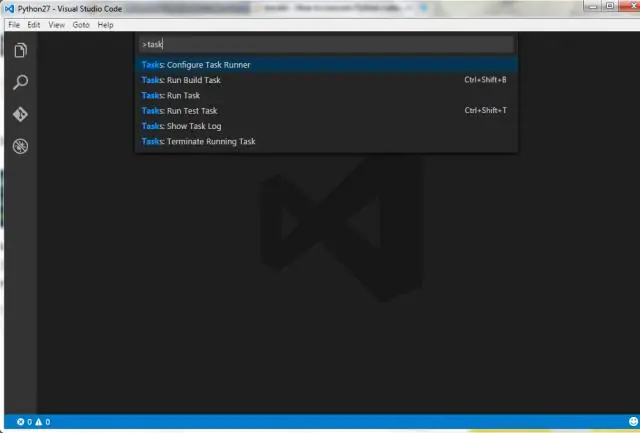

ฉันสามารถเขียนโค้ด Python ใน Visual Studio ได้หรือไม่

Python ในโค้ด Visual Studio การทำงานกับ Python ใน Visual Studio Code โดยใช้ส่วนขยาย Microsoft Python นั้นง่าย สนุก และมีประสิทธิภาพ ส่วนขยายนี้ทำให้ VS Code เป็นเครื่องมือแก้ไข Python ที่ยอดเยี่ยม และทำงานบนระบบปฏิบัติการใดๆ ที่มีตัวแปล Python ที่หลากหลาย

คลาสอ็อบเจ็กต์หมายถึงอะไรใน Python

คลาสคือเทมเพลตโค้ดสำหรับสร้างออบเจกต์ วัตถุมีตัวแปรสมาชิกและมีพฤติกรรมที่เกี่ยวข้องกับพวกมัน ใน python คลาสถูกสร้างขึ้นโดยคลาสคีย์เวิร์ด วัตถุถูกสร้างขึ้นโดยใช้ตัวสร้างของคลาส วัตถุนี้จะถูกเรียกว่าอินสแตนซ์ของคลาส

รูปแบบการออกแบบ Python คืออะไร?

รูปแบบการออกแบบของ Python เป็นวิธีที่ยอดเยี่ยมในการควบคุมศักยภาพอันมหาศาลของมัน ตัวอย่างเช่น Factory เป็นรูปแบบการออกแบบโครงสร้าง Python ที่มุ่งสร้างวัตถุใหม่ โดยซ่อนตรรกะการสร้างอินสแตนซ์จากผู้ใช้ แต่การสร้างอ็อบเจกต์ใน Python นั้นเป็นไดนามิกโดยการออกแบบ ดังนั้นการเพิ่มเติมอย่าง Factory จึงไม่จำเป็น

Python ขูดคืออะไร?

การขูดเว็บด้วย Python การขูดเว็บเป็นคำที่ใช้อธิบายการใช้โปรแกรมหรืออัลกอริธึมในการดึงและประมวลผลข้อมูลจำนวนมากจากเว็บ ไม่ว่าคุณจะเป็นนักวิทยาศาสตร์ข้อมูล วิศวกร หรือใครก็ตามที่วิเคราะห์ชุดข้อมูลจำนวนมาก ความสามารถในการดึงข้อมูลจากเว็บเป็นทักษะที่มีประโยชน์