- ผู้เขียน Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:54.

- แก้ไขล่าสุด 2025-01-22 17:43.

1) ปัญหาไฟล์เล็ก ใน HDFS : เก็บของ ไฟล์ขนาดเล็ก ซึ่งเป็นอย่างมาก เล็กกว่า กว่าขนาดบล็อกไม่สามารถจัดการได้อย่างมีประสิทธิภาพโดย HDFS . การอ่านผ่าน ไฟล์ขนาดเล็ก เกี่ยวข้องกับการค้นหาและการกระโดดข้ามระหว่างโหนดข้อมูลไปยังโหนดข้อมูลเป็นจำนวนมากซึ่งเป็นการประมวลผลข้อมูลที่ไม่มีประสิทธิภาพ

นอกจากนี้ ไฟล์ใดบ้างที่จัดการกับปัญหาไฟล์ขนาดเล็กใน Hadoop

1) ฮาร์ ( Hadoop คลังเก็บเอกสารสำคัญ) ไฟล์ ได้รับการแนะนำให้รู้จักกับ จัดการกับปัญหาไฟล์ขนาดเล็ก . HAR ได้แนะนำเลเยอร์ที่ด้านบนของ HDFS ซึ่งให้อินเทอร์เฟซสำหรับ ไฟล์ การเข้าถึง โดยใช้ Hadoop คำสั่งเก็บถาวร HAR ไฟล์ ถูกสร้างขึ้น ซึ่งรัน a แผนที่ลด งานแพ็ค ไฟล์ ถูกเก็บไว้ใน เล็กกว่า จำนวน ไฟล์ HDFS.

นอกจากนี้ ฉันสามารถมีหลายไฟล์ใน HDFS ใช้ขนาดบล็อกที่ต่างกันได้หรือไม่ ค่าเริ่มต้น ขนาด ของ บล็อก คือ 64 MB คุณ สามารถ เปลี่ยนตามความต้องการของคุณ มาถึงคำถามของคุณใช่คุณ สามารถสร้างได้หลายไฟล์ โดยแตกต่างกัน ขนาดบล็อก แต่ในแบบเรียลไทม์นี้ จะ ไม่ชอบการผลิต

ยิ่งไปกว่านั้น เหตุใด HDFS จึงไม่จัดการไฟล์ขนาดเล็กอย่างเหมาะสม

มีปัญหากับ ไฟล์ขนาดเล็ก และ HDFS ทั้งหมด ไฟล์ , ไดเรกทอรีและบล็อกใน HDFS คือ แสดงเป็นวัตถุในหน่วยความจำของ namenode ซึ่งแต่ละอันมีพื้นที่ 150 ไบต์ ตามกฎทั่วไป นอกจากนี้, HDFS ไม่ใช่ มุ่งสู่การเข้าถึงอย่างมีประสิทธิภาพ ไฟล์ขนาดเล็ก : มัน เป็น ออกแบบมาสำหรับการเข้าถึงสตรีมมิ่งขนาดใหญ่ ไฟล์.

ทำไม Hadoop ถึงช้า?

ช้า ความเร็วในการประมวลผล ดิสก์นี้ต้องใช้เวลาจึงทำให้กระบวนการทั้งหมดเป็นอย่างมาก ช้า . ถ้า Hadoop ประมวลผลข้อมูลในปริมาณน้อย มาก ช้า เปรียบเทียบ เหมาะอย่างยิ่งสำหรับชุดข้อมูลขนาดใหญ่ เนื่องจาก Hadoop มีเอ็นจิ้นการประมวลผลแบบกลุ่มที่แกนกลาง ความเร็วสำหรับการประมวลผลแบบเรียลไทม์นั้นน้อยกว่า

แนะนำ:

Namenode รองใน Apache Hadoop คืออะไร

NameNode รองใน hadoop เป็นโหนดเฉพาะในคลัสเตอร์ HDFS ซึ่งมีหน้าที่หลักคือใช้จุดตรวจสอบของข้อมูลเมตาของระบบไฟล์ที่แสดงอยู่บน namenode ไม่ใช่เนมโหนดสำรอง มันแค่จุดตรวจเนมสเปซระบบไฟล์ของ namenode

HDP ใน Hadoop คืออะไร?

Hortonworks Data Platform (HDP) เป็นระบบการแจกจ่าย Apache Hadoop แบบโอเพ่นซอร์สที่มีความปลอดภัยสูง พร้อมสำหรับองค์กร โดยใช้สถาปัตยกรรมแบบรวมศูนย์ (YARN) HDP ตอบสนองความต้องการของข้อมูลที่อยู่นิ่ง ขับเคลื่อนแอปพลิเคชันของลูกค้าแบบเรียลไทม์ และนำเสนอการวิเคราะห์ที่มีประสิทธิภาพซึ่งช่วยเร่งการตัดสินใจและนวัตกรรม

กรดใน Hadoop คืออะไร?

ACID ย่อมาจาก Atomicity, Consistency, Isolation และ Durability ความสม่ำเสมอทำให้แน่ใจได้ว่าธุรกรรมใดๆ จะนำฐานข้อมูลจากสถานะที่ถูกต้องหนึ่งไปยังอีกสถานะหนึ่ง Isolation ระบุว่าทุกธุรกรรมควรเป็นอิสระจากกัน กล่าวคือ ธุรกรรมหนึ่งไม่ควรส่งผลกระทบกับอีกธุรกรรมหนึ่ง

Data lineage ใน Hadoop คืออะไร?

สายข้อมูล สายข้อมูลสามารถกำหนดเป็นวงจรชีวิตและสิ้นสุดการไหลของข้อมูล Data lineage ช่วยให้บริษัทต่างๆ สามารถติดตามแหล่งที่มาของข้อมูลธุรกิจเฉพาะ ซึ่งช่วยให้สามารถติดตามข้อผิดพลาด นำการเปลี่ยนแปลงไปใช้ในกระบวนการ และใช้การโยกย้ายระบบเพื่อประหยัดเวลาได้อย่างมาก

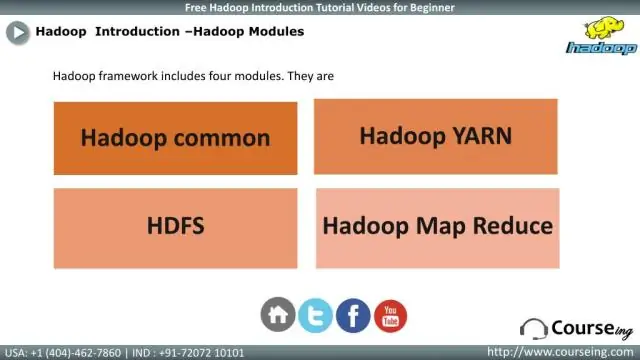

Hadoop framework PPT คืออะไร?

PPT บน Hadoop ไลบรารีซอฟต์แวร์ Apache Hadoop เป็นเฟรมเวิร์กที่อนุญาตให้มีการประมวลผลแบบกระจายของชุดข้อมูลขนาดใหญ่ทั่วทั้งคลัสเตอร์ของคอมพิวเตอร์โดยใช้โมเดลการเขียนโปรแกรมอย่างง่าย