- ผู้เขียน Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- แก้ไขล่าสุด 2025-01-22 17:42.

ด้วยตัวเลือกระหว่างภาษาโปรแกรมเช่น Java, Scala และ Python สำหรับ Hadoop ระบบนิเวศที่นักพัฒนาส่วนใหญ่ใช้ Python เนื่องจากห้องสมุดสนับสนุนสำหรับงานวิเคราะห์ข้อมูล Hadoop สตรีมมิ่งช่วยให้ผู้ใช้สามารถสร้างและ ดำเนินการ แมป/ลดงานด้วยสคริปต์ใดๆ หรือปฏิบัติการได้ในฐานะผู้ทำแผนที่หรือ/และตัวลดขนาด

ในทำนองเดียวกัน มีคนถามว่า Python เชื่อมต่อกับ Hadoop อย่างไร

การเชื่อมต่อ Hadoop HDFS กับ Python

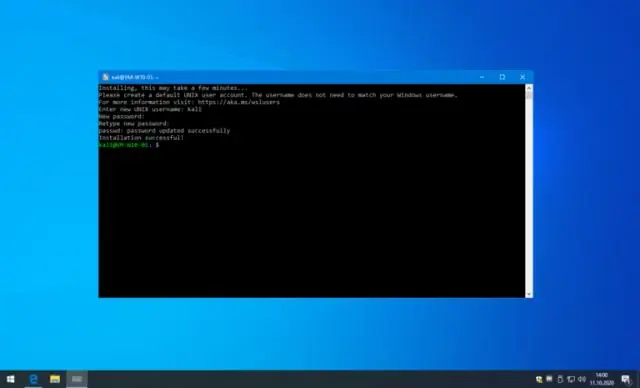

- ขั้นที่ 1: ตรวจสอบให้แน่ใจว่า Hadoop HDFS ทำงานอย่างถูกต้อง เปิด Terminal/Command Prompt ตรวจสอบว่า HDFS ทำงานโดยใช้คำสั่งต่อไปนี้ start-dfs.sh

- ขั้นตอนที่ 2: ติดตั้งไลบรารี libhdfs3

- ขั้นตอนที่ 3: ติดตั้งไลบรารี hdfs3

- ขั้นตอนที่ 4: ตรวจสอบว่าการเชื่อมต่อกับ HDFS สำเร็จหรือไม่

ในทำนองเดียวกัน Hadoop ใน Python คืออะไร? Python เป็นวัตถุประสงค์ทั่วไปของภาษาการเขียนโปรแกรมที่สมบูรณ์ซึ่งสามารถใช้ทำเกือบทุกอย่างในโลกการเขียนโปรแกรม Hadoop เป็นกรอบงานข้อมูลขนาดใหญ่ที่เขียนด้วยภาษาจาวาเพื่อจัดการกับข้อมูลปริมาณมหาศาล มีสถาบันออนไลน์มากมายที่ Hadoop กับ Python หลักสูตรต่างๆ เช่น Analytixlabs เอดูเรก้า.

ต่อมา คำถามคือ ฉันจะรันโปรแกรม Python MapReduce ใน Hadoop ได้อย่างไร

การเขียนโปรแกรม Hadoop MapReduce ใน Python

- แรงจูงใจ.

- สิ่งที่เราอยากทำ

- ข้อกำหนดเบื้องต้น

- โค้ด Python MapReduce ขั้นตอนการทำแผนที่: mapper.py ลดขั้นตอน: reducer.py

- การรันโค้ด Python บน Hadoop ดาวน์โหลดตัวอย่างข้อมูลอินพุต คัดลอกข้อมูลตัวอย่างในเครื่องไปยัง HDFS

- ปรับปรุงโค้ด Mapper และ Reducer: ใช้ตัววนซ้ำและตัวสร้าง Python mapper.py ลดขนาด.py

Hadoop Streaming jar คืออะไร?

Hadoop การแจกจ่ายให้ยูทิลิตี้ Java ที่เรียกว่า Hadoop สตรีมมิ่ง . บรรจุใน ไห ไฟล์. กับ Hadoop สตรีมมิ่ง เราสามารถสร้างและเรียกใช้งาน Map Reduce ด้วยสคริปต์ที่ปฏิบัติการได้ Hadoop สตรีมมิ่ง เป็นยูทิลิตี้ที่มาพร้อมกับ Hadoop การกระจาย. สามารถใช้รันโปรแกรมสำหรับการวิเคราะห์ข้อมูลขนาดใหญ่ได้

แนะนำ:

ฉันสามารถเรียกใช้ Windows และ Mac บนพีซีเครื่องเดียวกันได้หรือไม่

หากคุณเป็นเจ้าของ Mac ที่ใช้ Intel คุณสามารถใช้งานทั้ง OS X และ Windows บนคอมพิวเตอร์เครื่องเดียวกันได้ คอมพิวเตอร์พีซีส่วนใหญ่ใช้ชิปที่ใช้ Intel ซึ่งหมายความว่าขณะนี้คุณสามารถเรียกใช้ระบบปฏิบัติการ Windows และ OS X บนคอมพิวเตอร์ Mac ได้

ฉันสามารถเรียกใช้ Malwarebytes และ McAfee พร้อมกันได้หรือไม่

ใช่ Mcafee ให้การป้องกันที่แข็งแกร่ง แต่การมีมัลแวร์ไบต์น่าจะใช้ได้ดีหากคุณคิดว่ามีบางสิ่งที่อาจแอบผ่าน mcafee หรือผลิตภัณฑ์ที่คุณติดตั้ง ทำงานขณะสแกนเท่านั้น

ฉันสามารถเรียกใช้ MS Office บน Linux ได้หรือไม่

ผู้ใช้ Linux สามารถใช้ LibreOffice, GoogleDocs และแม้แต่ Office Web Apps ของ Microsoft แต่บางคนยังต้องการหรือเพียงแค่ต้องการ Microsoft Office เวอร์ชันเดสก์ท็อป โชคดีที่มีวิธีเรียกใช้ Microsoft Office บน Linux เห็นได้ชัดว่า Microsoft ไม่รองรับสิ่งนี้ แต่ก็ยังใช้งานได้ค่อนข้างดี

ฉันสามารถเรียกใช้ Docker บน Windows Server 2016 ได้หรือไม่

ติดตั้ง Docker Engine - Enterprise บนเซิร์ฟเวอร์ Windows Docker Engine - Enterprise เปิดใช้งานคอนเทนเนอร์ Docker ดั้งเดิมบน Windows Server รองรับ Windows Server 2016 และเวอร์ชันที่ใหม่กว่า แพ็คเกจการติดตั้ง Docker Engine - Enterprise มีทุกสิ่งที่คุณต้องการเพื่อเรียกใช้ Docker บน Windows Server

ฉันสามารถเรียกใช้ spark ในเครื่องได้หรือไม่

Spark สามารถเรียกใช้ได้โดยใช้ตัวจัดกำหนดการคลัสเตอร์แบบสแตนด์อโลนในตัวในโหมดโลคัล ซึ่งหมายความว่ากระบวนการ Spark ทั้งหมดทำงานภายใน JVM เดียวกันอย่างมีประสิทธิภาพ ซึ่งเป็นอินสแตนซ์เดี่ยวแบบมัลติเธรดของ Spark