- ผู้เขียน Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- แก้ไขล่าสุด 2025-01-22 17:42.

Spark ทำงานบน Java 8+ Python 2.7+/3.4+ และ R 3.1+ สำหรับ Scala API Spark 2.3. 0 ใช้ สกาล่า 2.11. คุณจะต้อง ใช้ Scala. ที่เข้ากันได้ รุ่น (2.11.

สอดคล้องกัน spark ทำงานกับ Python 3 หรือไม่

Apache Spark เป็นเฟรมเวิร์กการประมวลผลแบบคลัสเตอร์ ซึ่งปัจจุบันเป็นหนึ่งในเฟรมเวิร์กของ Big Data แบบโอเพนซอร์สที่ได้รับการพัฒนาอย่างแข็งขันที่สุด ตั้งแต่เวอร์ชั่นล่าสุด 1.4 (มิถุนายน 2558) Spark รองรับ R และ Python3 (เพื่อเสริมการรองรับก่อนหน้านี้สำหรับ Java, Scala และ Python 2).

ด้านบน ฉันจะเปลี่ยนเวอร์ชัน Spark ของ Python ได้อย่างไร ในกรณีที่คุณต้องการเพียง เปลี่ยน NS เวอร์ชันหลาม สำหรับงานปัจจุบัน คุณสามารถใช้คำสั่ง pyspark start ต่อไปนี้: PYSPARK_DRIVER_PYTHON=/home/user1/anaconda2/bin/ หลาม PYSPARK_PYTHON=/usr/local/anaconda2/bin/ หลาม pyspark --มาสเตอร์..

นอกจากนี้ Spark เวอร์ชันล่าสุดคืออะไร?

Apache Spark

| ผู้เขียนต้นฉบับ | มาเตย์ ซาฮาเรีย |

|---|---|

| เปิดตัวครั้งแรก | 26 พฤษภาคม 2014 |

| ปล่อยที่มั่นคง | 2.4.5 / 8 กุมภาพันธ์ 2020 |

| ที่เก็บ | Spark Repository |

| เขียนใน | สกาลา |

spark Python คืออะไร?

ฝึก Big Data ด้วย Apache Spark และ Python Py4J เป็นห้องสมุดยอดนิยมที่รวมอยู่ภายใน PySpark ที่ช่วยให้ หลาม อินเทอร์เฟซแบบไดนามิกกับวัตถุ JVM (RDD's) Apache Spark มาพร้อมกับเปลือกโต้ตอบสำหรับ หลาม เช่นเดียวกับสกาล่า เปลือกสำหรับ หลาม เรียกว่า “ PySpark ”.

แนะนำ:

MAP side join ใน spark คืออะไร?

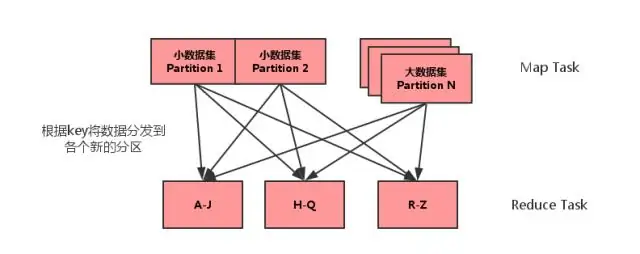

การรวมฝั่งแผนที่เป็นกระบวนการที่การรวมระหว่างสองตารางจะดำเนินการในเฟสแผนที่โดยไม่เกี่ยวข้องกับเฟสลด การรวมฝั่งแผนที่ช่วยให้สามารถโหลดตารางลงในหน่วยความจำเพื่อให้แน่ใจว่าการดำเนินการเข้าร่วมอย่างรวดเร็ว ดำเนินการทั้งหมดภายในตัวทำแผนที่ และสามารถทำได้โดยไม่ต้องใช้ทั้งแผนที่และลดขั้นตอน

มีอะไรใหม่ใน Spark?

นอกจากการแก้ไขข้อผิดพลาดแล้ว Spark 2.4 ยังมีคุณสมบัติใหม่ 2 อย่าง: SPARK-22239 ฟังก์ชั่นหน้าต่างที่ผู้ใช้กำหนดด้วย Pandas UDF SPARK-22274 ฟังก์ชันการรวมที่ผู้ใช้กำหนดด้วย pandas udf เราเชื่อว่าคุณสมบัติใหม่เหล่านี้จะปรับปรุงการนำ Pandas UDF ไปใช้งานต่อไป และเราจะปรับปรุง Pandas UDF ต่อไปในรุ่นถัดไป

ฉันจะตั้งค่าโปรแกรมส่งข้อความโต้ตอบแบบทันทีของ spark ได้อย่างไร

คู่มือการตั้งค่า Spark IM ดาวน์โหลด Spark จากเว็บไซต์ Spark IM ติดตั้งและเปิดใช้ Spark บนคอมพิวเตอร์ของคุณ ป้อนชื่อผู้ใช้ Olark ของคุณในช่องด้านบน รหัสผ่านของคุณในช่องตรงกลาง และ "@olark.com" สำหรับโดเมน กด Enter แล้วคุณจะเข้าสู่ Spark IM! แชทอย่างมีความสุข

ฉันจะเริ่มเซิร์ฟเวอร์ประวัติ spark ของฉันได้อย่างไร

วิธีเปิดใช้งานเซิร์ฟเวอร์ประวัติ Spark: สร้างไดเร็กทอรีสำหรับบันทึกเหตุการณ์ในระบบไฟล์ DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events เมื่อเปิดใช้งานการบันทึกเหตุการณ์ ลักษณะการทำงานเริ่มต้นคือการบันทึกทั้งหมด ซึ่งทำให้พื้นที่จัดเก็บเพิ่มขึ้นเมื่อเวลาผ่านไป

DataFrame ใน spark Scala คืออะไร

Spark DataFrame คือคอลเล็กชันข้อมูลที่กระจายซึ่งจัดเป็นคอลัมน์ที่มีชื่อซึ่งมีการดำเนินการเพื่อกรอง จัดกลุ่ม หรือคำนวณการรวม และสามารถใช้กับ Spark SQL ได้ สามารถสร้าง DataFrames จากไฟล์ข้อมูลที่มีโครงสร้าง RDD ที่มีอยู่ ตารางใน Hive หรือฐานข้อมูลภายนอก