- ผู้เขียน Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:54.

- แก้ไขล่าสุด 2025-01-22 17:43.

ในขณะที่ Spark รองรับการโหลด ไฟล์ จาก ท้องถิ่น ระบบไฟล์ มันต้องการให้ ไฟล์ มีอยู่ในเส้นทางเดียวกันบนโหนดทั้งหมดในคลัสเตอร์ของคุณ ระบบไฟล์เครือข่ายบางระบบ เช่น NFS, AFS และเลเยอร์ NFS ของ MapR ถูกเปิดเผยต่อผู้ใช้ในฐานะระบบไฟล์ปกติ

ต่อมาอาจมีคนถามว่าฉันจะเรียกใช้ spark ในโหมดท้องถิ่นได้อย่างไร

ใน โหมดท้องถิ่น , จุดประกาย งาน วิ่ง บนเครื่องเดียว และดำเนินการพร้อมกันโดยใช้มัลติเธรด: สิ่งนี้จะจำกัดการขนาน (อย่างมากที่สุด) ของจำนวนคอร์ในเครื่องของคุณ ถึง วิ่ง งานใน โหมดท้องถิ่น คุณต้องจองเครื่องผ่าน SLURM แบบโต้ตอบก่อน โหมด และเข้าสู่ระบบ

ด้านบนนี้ SC textFile คืออะไร? textFile เป็นวิธีการขององค์กร อาปาเช่ SparkContext ชั้นเรียนที่อ่านว่า a ไฟล์ข้อความ จาก HDFS ระบบไฟล์ในเครื่อง (พร้อมใช้งานบนโหนดทั้งหมด) หรือ URI ระบบไฟล์ที่รองรับ Hadoop และส่งคืนเป็น RDD ของสตริง

ในเรื่องนี้ไฟล์ spark คืออะไร?

NS ไฟล์ Spark เป็นเอกสารที่คุณเก็บความดีความคิดสร้างสรรค์ของคุณไว้ มันถูกกำหนดโดยผู้เขียนสตีเฟ่นจอห์นสัน ดังนั้น แทนที่จะขีดเขียนโน้ตบน Post-it® กลางดึกหรือจดบันทึกความคิดต่าง ๆ คุณรวมแนวคิดทั้งหมดของคุณไว้ในที่เดียว ไฟล์.

จุดประกายการรวบรวมแบบขนานคืออะไร?

เราอธิบายการดำเนินการกับชุดข้อมูลแบบกระจายในภายหลัง คอลเลกชันคู่ขนาน ถูกสร้างขึ้นโดยการเรียก JavaSparkContext 's ขนานกัน วิธีการที่มีอยู่ ของสะสม ในโปรแกรมไดรเวอร์ของคุณ องค์ประกอบของ ของสะสม ถูกคัดลอกเพื่อสร้างชุดข้อมูลแบบกระจายที่สามารถดำเนินการแบบคู่ขนานได้

แนะนำ:

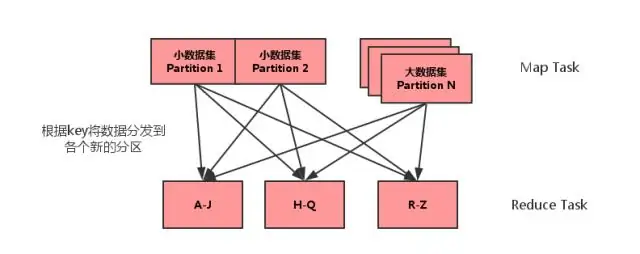

MAP side join ใน spark คืออะไร?

การรวมฝั่งแผนที่เป็นกระบวนการที่การรวมระหว่างสองตารางจะดำเนินการในเฟสแผนที่โดยไม่เกี่ยวข้องกับเฟสลด การรวมฝั่งแผนที่ช่วยให้สามารถโหลดตารางลงในหน่วยความจำเพื่อให้แน่ใจว่าการดำเนินการเข้าร่วมอย่างรวดเร็ว ดำเนินการทั้งหมดภายในตัวทำแผนที่ และสามารถทำได้โดยไม่ต้องใช้ทั้งแผนที่และลดขั้นตอน

มีอะไรใหม่ใน Spark?

นอกจากการแก้ไขข้อผิดพลาดแล้ว Spark 2.4 ยังมีคุณสมบัติใหม่ 2 อย่าง: SPARK-22239 ฟังก์ชั่นหน้าต่างที่ผู้ใช้กำหนดด้วย Pandas UDF SPARK-22274 ฟังก์ชันการรวมที่ผู้ใช้กำหนดด้วย pandas udf เราเชื่อว่าคุณสมบัติใหม่เหล่านี้จะปรับปรุงการนำ Pandas UDF ไปใช้งานต่อไป และเราจะปรับปรุง Pandas UDF ต่อไปในรุ่นถัดไป

Spark ใช้เวอร์ชันใดของ Python

Spark ทำงานบน Java 8+, Python 2.7+/3.4+ และ R 3.1+ สำหรับ Scala API, Spark 2.3 0 ใช้ Scala 2.11 คุณจะต้องใช้เวอร์ชัน Scala ที่เข้ากันได้ (2.11

ฉันจะตั้งค่าโปรแกรมส่งข้อความโต้ตอบแบบทันทีของ spark ได้อย่างไร

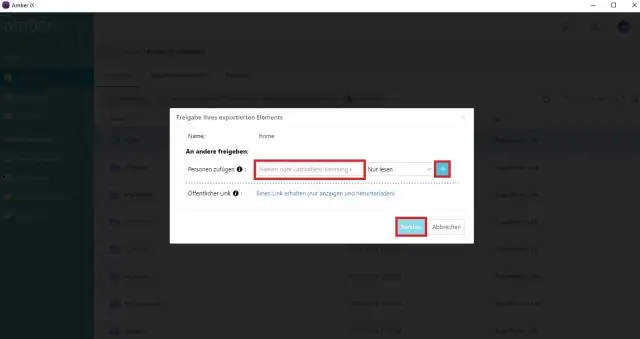

คู่มือการตั้งค่า Spark IM ดาวน์โหลด Spark จากเว็บไซต์ Spark IM ติดตั้งและเปิดใช้ Spark บนคอมพิวเตอร์ของคุณ ป้อนชื่อผู้ใช้ Olark ของคุณในช่องด้านบน รหัสผ่านของคุณในช่องตรงกลาง และ "@olark.com" สำหรับโดเมน กด Enter แล้วคุณจะเข้าสู่ Spark IM! แชทอย่างมีความสุข

ฉันจะเริ่มเซิร์ฟเวอร์ประวัติ spark ของฉันได้อย่างไร

วิธีเปิดใช้งานเซิร์ฟเวอร์ประวัติ Spark: สร้างไดเร็กทอรีสำหรับบันทึกเหตุการณ์ในระบบไฟล์ DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events เมื่อเปิดใช้งานการบันทึกเหตุการณ์ ลักษณะการทำงานเริ่มต้นคือการบันทึกทั้งหมด ซึ่งทำให้พื้นที่จัดเก็บเพิ่มขึ้นเมื่อเวลาผ่านไป