- ผู้เขียน Lynn Donovan [email protected].

- Public 2023-12-15 23:54.

- แก้ไขล่าสุด 2025-01-22 17:43.

เริ่ม Spark ควบคุมหลายโหนดและตรวจดูให้แน่ใจว่าโหนดเหล่านี้มีเหมือนกัน ผู้ดูแลสวนสัตว์ การกำหนดค่าสำหรับ ZooKeeper URL และไดเรกทอรี

ข้อมูล.

| คุณสมบัติของระบบ | ความหมาย |

|---|---|

| จุดประกาย .ปรับใช้. ผู้ดูแลสวนสัตว์ .dir | ไดเร็กทอรีใน ZooKeeper เพื่อจัดเก็บสถานะการกู้คืน (ค่าเริ่มต้น: / จุดประกาย ). สามารถเลือกได้ |

คุณสามารถเรียกใช้ Spark ในพื้นที่ได้หรือไม่?

หัวเทียน เป็น วิ่ง โดยใช้ตัวกำหนดเวลาคลัสเตอร์แบบสแตนด์อโลนในตัวใน ท้องถิ่น โหมด. ซึ่งหมายความว่า. ทั้งหมด Spark กระบวนการคือ วิ่ง ภายใน JVM เดียวกันอย่างมีประสิทธิภาพ อินสแตนซ์เดียวแบบมัลติเธรดของ Spark.

ประการที่สอง Spark สามารถใช้โดยไม่มี Hadoop ได้หรือไม่? ตามที่ Spark เอกสาร, หัวเทียน วิ่ง ไม่มี Hadoop . คุณสามารถเรียกใช้เป็นโหมดสแตนด์อโลน ปราศจาก ผู้จัดการทรัพยากรใด ๆ แต่ถ้าคุณต้องการทำงานในการตั้งค่าแบบหลายโหนด คุณต้องมีตัวจัดการทรัพยากร เช่น YARN หรือ Mesos และระบบไฟล์แบบกระจาย เช่น HDFS , S3 เป็นต้น ใช่ หัวเทียน วิ่ง ไร้ฮาดูป.

สิ่งที่ควรทราบก็คือ เหตุใด ZooKeeper จึงถูกใช้ใน Hadoop

ผู้ดูแลสวนสัตว์ ใน Hadoop สามารถดูได้ว่าเป็นพื้นที่เก็บข้อมูลแบบรวมศูนย์ซึ่งแอปพลิเคชันแบบกระจายสามารถใส่ข้อมูลและรับข้อมูลได้ มันคือ ใช้แล้ว เพื่อให้ระบบแบบกระจายทำงานประสานกันเป็นหน่วยเดียว โดยใช้เป้าหมายการซิงโครไนซ์ การซีเรียลไลซ์เซชัน และการประสานงาน

spark แบบสแตนด์อโลนทำงานอย่างไร

สแตนด์อโลน โหมดเป็นตัวจัดการคลัสเตอร์อย่างง่ายที่รวมเข้ากับ Spark . ทำให้ง่ายต่อการติดตั้งคลัสเตอร์ที่ Spark ตัวมันเองจัดการและสามารถทำงานบน Linux, Windows หรือ Mac OSX มักจะเป็นวิธีที่ง่ายที่สุดในการวิ่ง Spark แอปพลิเคชันในสภาพแวดล้อมแบบคลัสเตอร์ เรียนรู้วิธีการติดตั้ง Apache Spark บน สแตนด์อโลน โหมด.

แนะนำ:

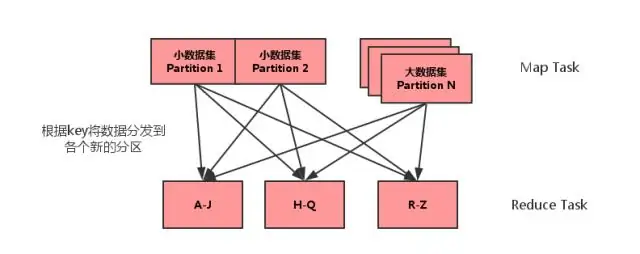

MAP side join ใน spark คืออะไร?

การรวมฝั่งแผนที่เป็นกระบวนการที่การรวมระหว่างสองตารางจะดำเนินการในเฟสแผนที่โดยไม่เกี่ยวข้องกับเฟสลด การรวมฝั่งแผนที่ช่วยให้สามารถโหลดตารางลงในหน่วยความจำเพื่อให้แน่ใจว่าการดำเนินการเข้าร่วมอย่างรวดเร็ว ดำเนินการทั้งหมดภายในตัวทำแผนที่ และสามารถทำได้โดยไม่ต้องใช้ทั้งแผนที่และลดขั้นตอน

มีอะไรใหม่ใน Spark?

นอกจากการแก้ไขข้อผิดพลาดแล้ว Spark 2.4 ยังมีคุณสมบัติใหม่ 2 อย่าง: SPARK-22239 ฟังก์ชั่นหน้าต่างที่ผู้ใช้กำหนดด้วย Pandas UDF SPARK-22274 ฟังก์ชันการรวมที่ผู้ใช้กำหนดด้วย pandas udf เราเชื่อว่าคุณสมบัติใหม่เหล่านี้จะปรับปรุงการนำ Pandas UDF ไปใช้งานต่อไป และเราจะปรับปรุง Pandas UDF ต่อไปในรุ่นถัดไป

Spark ใช้เวอร์ชันใดของ Python

Spark ทำงานบน Java 8+, Python 2.7+/3.4+ และ R 3.1+ สำหรับ Scala API, Spark 2.3 0 ใช้ Scala 2.11 คุณจะต้องใช้เวอร์ชัน Scala ที่เข้ากันได้ (2.11

ฉันจะตั้งค่าโปรแกรมส่งข้อความโต้ตอบแบบทันทีของ spark ได้อย่างไร

คู่มือการตั้งค่า Spark IM ดาวน์โหลด Spark จากเว็บไซต์ Spark IM ติดตั้งและเปิดใช้ Spark บนคอมพิวเตอร์ของคุณ ป้อนชื่อผู้ใช้ Olark ของคุณในช่องด้านบน รหัสผ่านของคุณในช่องตรงกลาง และ "@olark.com" สำหรับโดเมน กด Enter แล้วคุณจะเข้าสู่ Spark IM! แชทอย่างมีความสุข

ฉันจะเริ่มเซิร์ฟเวอร์ประวัติ spark ของฉันได้อย่างไร

วิธีเปิดใช้งานเซิร์ฟเวอร์ประวัติ Spark: สร้างไดเร็กทอรีสำหรับบันทึกเหตุการณ์ในระบบไฟล์ DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events เมื่อเปิดใช้งานการบันทึกเหตุการณ์ ลักษณะการทำงานเริ่มต้นคือการบันทึกทั้งหมด ซึ่งทำให้พื้นที่จัดเก็บเพิ่มขึ้นเมื่อเวลาผ่านไป