- ผู้เขียน Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:54.

- แก้ไขล่าสุด 2025-01-22 17:43.

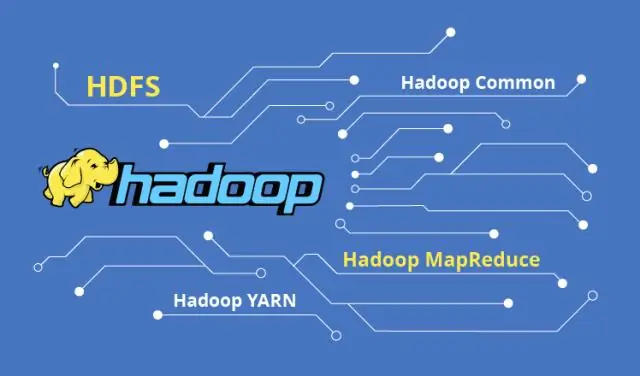

มีหลายวิธีในการนำเข้าข้อมูลที่ไม่มีโครงสร้างไปยัง Hadoop ขึ้นอยู่กับกรณีการใช้งานของคุณ

- โดยใช้ HDFS คำสั่งเชลล์เช่น put หรือ copyFromLocal เพื่อย้าย flat ไฟล์ เข้าไปข้างใน HDFS .

- การใช้ WebHDFS REST API สำหรับการรวมแอปพลิเคชัน

- การใช้ Apache Flume

- การใช้ Storm ซึ่งเป็นระบบประมวลผลเหตุการณ์เอนกประสงค์

ในเรื่องนี้ ข้อมูลที่ไม่มีโครงสร้างถูกเก็บไว้ใน Hadoop อย่างไร?

ข้อมูล ใน HDFS เป็น เก็บไว้ เป็นไฟล์. Hadoop ไม่ได้บังคับให้มีสคีมาหรือโครงสร้างกับ ข้อมูล ที่จะต้อง เก็บไว้ . ซึ่งช่วยให้สามารถใช้ Hadoop สำหรับโครงสร้างใด ๆ ข้อมูลที่ไม่มีโครงสร้าง แล้วส่งออกกึ่งโครงสร้างหรือโครงสร้าง ข้อมูล ลงในฐานข้อมูลดั้งเดิมเพื่อการวิเคราะห์ต่อไป

นอกจากนี้ คุณจะจัดการกับข้อมูลที่ไม่มีโครงสร้างอย่างไร ด้านล่างนี้คือ 10 ขั้นตอนที่ต้องปฏิบัติตามซึ่งจะช่วยวิเคราะห์ข้อมูลที่ไม่มีโครงสร้างสำหรับองค์กรธุรกิจที่ประสบความสำเร็จ

- ตัดสินใจเลือกแหล่งข้อมูล

- จัดการการค้นหาข้อมูลที่ไม่มีโครงสร้างของคุณ

- การกำจัดข้อมูลที่ไร้ประโยชน์

- เตรียมข้อมูลสำหรับการจัดเก็บข้อมูล

- ตัดสินใจเลือกเทคโนโลยีสำหรับกองข้อมูลและการจัดเก็บข้อมูล

- เก็บข้อมูลทั้งหมดไว้จนกว่าจะมีการจัดเก็บ

ในลักษณะนี้ เราสามารถจัดเก็บข้อมูลที่ไม่มีโครงสร้างใน Hive ได้หรือไม่

กำลังประมวลผลแบบไม่มีโครงสร้าง ข้อมูล โดยใช้ ไฮฟ์ ก็มี คุณ มีมัน รังผึ้ง มาใช้ในการประมวลผลอย่างมีประสิทธิภาพ ข้อมูลที่ไม่มีโครงสร้าง . สำหรับความต้องการการประมวลผลที่ซับซ้อนมากขึ้น คุณ อาจเปลี่ยนกลับไปเขียน UDF ที่กำหนดเองแทน การใช้นามธรรมในระดับที่สูงกว่าการเขียนโค้ด Map Reduce ในระดับต่ำมีประโยชน์มากมาย

เราสามารถแปลงข้อมูลที่ไม่มีโครงสร้างเป็นข้อมูลที่มีโครงสร้างได้หรือไม่

ในขั้นตอนนี้ ข้อมูลที่ไม่มีโครงสร้าง ถูกแปลงเป็น ข้อมูลที่มีโครงสร้าง โดยที่กลุ่มของคำที่พบตามการจัดประเภทจะได้รับการกำหนดค่า คำที่เป็นบวกอาจเท่ากับ 1, ค่าลบ -1 และค่าเป็นกลาง 0 นี่ ข้อมูลที่ไม่มีโครงสร้างสามารถ ตอนนี้ถูกจัดเก็บและวิเคราะห์เป็น คุณ จะด้วย ข้อมูลที่มีโครงสร้าง.

แนะนำ:

Hadoop การจัดตารางงานคืออะไร?

ตารางงาน. คุณสามารถใช้การจัดกำหนดการงานเพื่อจัดลำดับความสำคัญของงาน MapReduce และแอปพลิเคชัน YARN ที่ทำงานบนคลัสเตอร์ MapR ของคุณ ตัวกำหนดตารางเวลางานเริ่มต้นคือ Fair Scheduler ซึ่งออกแบบมาสำหรับสภาพแวดล้อมการผลิตที่มีผู้ใช้หลายคนหรือกลุ่มที่แข่งขันกันเพื่อแย่งชิงทรัพยากรของคลัสเตอร์

Namenode รองใน Apache Hadoop คืออะไร

NameNode รองใน hadoop เป็นโหนดเฉพาะในคลัสเตอร์ HDFS ซึ่งมีหน้าที่หลักคือใช้จุดตรวจสอบของข้อมูลเมตาของระบบไฟล์ที่แสดงอยู่บน namenode ไม่ใช่เนมโหนดสำรอง มันแค่จุดตรวจเนมสเปซระบบไฟล์ของ namenode

ฉันจะเป็นผู้ดูแลระบบ Hadoop ได้อย่างไร

ขั้นตอนในการเป็นผู้ดูแลระบบ Hadoop ทำความเข้าใจพื้นฐานและลักษณะของ Big Data และใช้สิ่งเหล่านี้เพื่อช่วยให้องค์กรจัดการ Big Data ทำงานกับไคลเอนต์ Hadoop และเว็บอินเตอร์เฟส ใช้การวางแผนคลัสเตอร์และเครื่องมือสำหรับการป้อนข้อมูลลงในคลัสเตอร์ Hadoop ใช้ส่วนประกอบ Hadoop ภายในระบบนิเวศ Hadoop

ฉันจะสร้างโฟลเดอร์ในระบบไฟล์ Hadoop ได้อย่างไร

สร้างไดเร็กทอรีใน HDFS การใช้งาน: $ hdfs dfs -mkdir แสดงรายการเนื้อหาของไดเร็กทอรีใน HDFS อัปโหลดไฟล์ไปยัง HDFS ดาวน์โหลดไฟล์จาก HDFS ตรวจสอบสถานะไฟล์ใน HDFS ดูเนื้อหาของไฟล์ในรูปแบบ HDFS คัดลอกไฟล์จากต้นทางไปยังปลายทางใน HDFS คัดลอกไฟล์จาก/ไปยังระบบไฟล์ในเครื่องไปยัง HDFS

ฉันจะดูขนาดไฟล์ใน Hadoop ได้อย่างไร

2 คำตอบ คุณสามารถใช้คำสั่ง hadoop fs -ls คำสั่งนี้แสดงรายการไฟล์ในไดเร็กทอรีปัจจุบันและรายละเอียดทั้งหมด ในผลลัพธ์ของคำสั่งนี้ คอลัมน์ที่ 5 จะแสดงขนาดไฟล์เป็นไบต์